21/11/2010

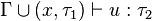

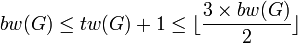

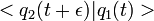

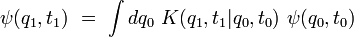

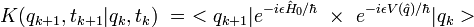

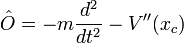

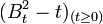

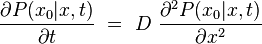

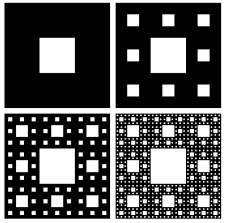

Complexes - Forme algébrique, équations, interprétation géométrique

Complexes - Forme algébrique, équations, interprétation géométrique

z = a + ib

![]()

(voir: second degré)

10:05 Publié dans Complexes - Forme algébrique, équations | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

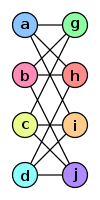

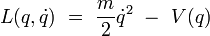

Produit scalaire

Source : http://fr.wikipedia.org/wiki/Produit_scalaire

Produit scalaire

En géométrie vectorielle, le produit scalaire est une opération algébrique s'ajoutant aux lois s'appliquant aux vecteurs. À deux vecteurs elle associe leur produit, qui est un nombre (ouscalaire). Elle permet d'exploiter les notions de la géométrie euclidienne traditionnelle : longueurs, angles, orthogonalité en dimension deux et trois, mais aussi de les étendre à des espaces vectoriels réels de toute dimension, et aux espaces vectoriels complexes.

Comme il existe deux grandes manières de définir les vecteurs, soit par une approche purement algébrique (cf espace vectoriel), soit par une approche géométrique à l'aide des bipoints(ou couple ordonné de points, cf Vecteur), il existe de même deux manières de présenter le produit scalaire : une manière algébrique, (objet de l'article Espace préhilbertien) et une manière géométrique, à l'aide de bipoints.

L'objectif de cet article est de présenter le produit scalaire de manière géométrique dans un espace euclidien traditionnel et de montrer comment cette notion peut s'étendre à tout espace vectoriel.

Sommaire[masquer] |

Aperçu des applications du produit scalaire [modifier]

Le produit scalaire possède de multiples applications. En physique, il est, par exemple, utilisé pour modéliser le travail d'une force. En géométrie analytique il permet de déterminer le caractère perpendiculaire de deux droites ou d'une droite et d'un plan. Ce domaine est le sujet de cet article. Dans le cas de la dimension finie quelconque, il dispose de nombreuses applications algébriques : il permet de classifier les quadriques, offre des outils pour la réduction d'endomorphismes ou encore est à la base de multiples techniques statistiques comme la méthode des moindres carrés ou l'analyse en composantes principales. En géométrie, il confère à l'espace vectoriel une structure d'espace métrique disposant de nombreuses propriétés comme la complétude. Ces applications sont traitées dans les articles Espace euclidien et Espace hermitien. Le produit scalaire est aussi utilisé dans des espaces de dimension infinie, il permet alors de résoudre des équations aux dérivées partielles. La théorie devient plus subtile et de nombreux résultats, vrais en dimension finie, prennent une autre forme. Cet aspect du produit scalaire est traité dans les articles Espace préhilbertien et Espace de Hilbert.

Enfin, l'article géométrie euclidienne propose une synthèse de l'histoire, des implications et applications du produit scalaire en dimension finie.

Fragments d'histoire [modifier]

Élément important de calcul en géométrie euclidienne, le produit scalaire apparaît cependant assez tard dans l'histoire des mathématiques. On en trouve trace chez Hamilton en 1843 lorsqu'il crée le corps des quaternions. Peano le définit ensuite associé à un calcul d'aire ou de déterminant. Roberto Marcolongo et Cesare Burali-Forti le définissent seulement à l'aide du cosinus d'un angle et lui donnent le nom de produit intérieur ou produit scalaire. C'est sous cette forme qu'il apparaît par la suite. Sa qualité de forme bilinéaire symétrique sera ensuite exploitée en algèbre linéaire et, de propriété, deviendra définition.

La notation du produit scalaire à l'aide d'un point ou d'une croix provient de Josiah Willard Gibbs, dans les années 1880.

Pourtant, selon le site Earliest known uses of some of the mathematical words, l'expression produit scalaire apparait pour la première fois dans une publication scientifique dans un livre de William Kingdon Clifford daté de 1878. Cette paternité est néanmoins remise en cause par M. J Crowe pour qui Clifford est une transition entre l'algèbre des quaternions décrite par Hamilton et la formalisation des espaces vectoriels.

Définitions et premières propriétés [modifier]

Dans cette section, on considèrera un espace traditionnel tel qu'il est défini par Euclide : plan ou espace formé de points dans lequel les notions de distance et d'angle sont connues. On sait aussi calculer le cosinus de tout angle géométrique. Sont également utilisables le théorème de Pythagore, celui d'Al-Kashi et le théorème de Thalès. La construction géométrique des vecteurs dans un tel espace est détaillée dans l'article Vecteur.

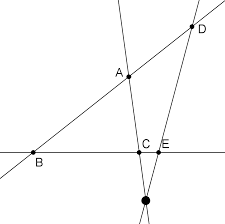

Soient deux vecteurs représentés par des bipoints de mêmes origines (O, A) et (O, B). De tels représentants existent quel que soit le choix des vecteurs. Dans le reste de l'article, la longueur du bipoint (O, A) est notée OA ou parfois |OA|, c'est donc un nombre réel positif.

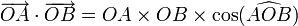

- Définition :

- Etant donnés des points O, A et B, on considère les vecteurs représentés par les bipoints OA et OB.

- Lorsque ces vecteurs sont non nuls le produit scalaire est le nombre réel OA·OB·cos(θ) où θ représente l'angle orienté AOB.

- Si l'un des vecteurs est nul alors le produit scalaire est nul.

- Dans tous les cas, on note ce produit scalaire :

Dans le cas où aucun des vecteurs n'est nul, cette définition prend la forme suivante :

Ici cos désigne la fonction mathématique cosinus et  représente l'angle géométrique de sommet O dessiné par les points A, O et B.

représente l'angle géométrique de sommet O dessiné par les points A, O et B.

Dans le cas où les deux vecteurs sont égaux, la notation suivante est utilisée :

La valeur du produit scalaire correspond alors à l'aire d'un carré de côté OA.

- Définition :

- La norme euclidienne d'un vecteur représenté par un bipoint AB est la distance qui sépare A de B. En général, elle est notée

.

. - Elle est égale à la racine carrée du produit scalaire du vecteur avec lui-même.

![left| overrightarrow {AB} right| = sqrt[]{overrightarrow {AB}cdotoverrightarrow {AB}}](http://upload.wikimedia.org/math/f/8/6/f86ba421646aa922511015ee1522f466.png)

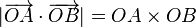

Une inégalité évidente est vérifiée par le produit scalaire ainsi défini :

- Inégalité de Cauchy-Schwarz

- Soient O, A et B trois points du plan, la valeur absolue du produit scalaire des deux vecteurs d'extrémités O, A et O, B est toujours inférieure ou égale au produit des normes des deux vecteurs. Cette majoration s'écrit :

L'égalité a lieu si et seulement si les trois points sont alignés. Cette majoration provient du fait que la fonction cosinus prend ses valeurs dans l'intervalle d'extrémité 1 et -1. Pour que l'égalité ait lieu, il faut et il suffit que le cosinus ait pour valeur soit 1 soit -1, c'est-à-dire que l'angle soit nul ou plat. Ce qui signifie bien que les trois points sont alignés. Une fois encore, cette inégalité est l'objet de l'article Inégalité de Cauchy-Schwarz, l'article suppose encore une formalisation algébrique différente de celle choisie ici.

Propriétés géométriques [modifier]

Projeté [modifier]

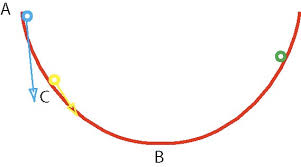

La définition précédente suppose connue la définition de la fonction cosinus. Il est possible d'éviter de faire appel à cette fonction.

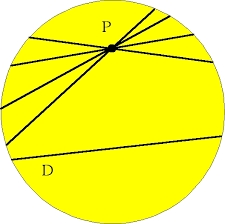

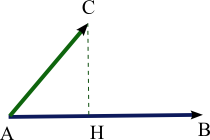

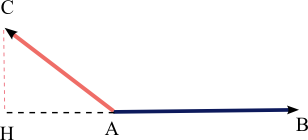

Soit A, B et C trois points distincts, la trigonométrie du triangle rectangle permet de calculer le produit scalaire grâce à une projection orthogonale. En effet, si H est le projeté orthogonal de C sur la droite (AB), le produit scalaire est alors en valeur absolue égal au produit des distances AH et AB. Si Ase trouve entre H et B, le produit scalaire est négatif et positif sinon. On remarque que si H est confondu avec A, alors le produit scalaire est nul.

|

|

|

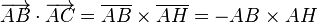

Le produit scalaire est parfois utilisé sous cette forme pour déterminer le travail d'une force lors d'un déplacement : Le travail de la force F selon le trajet u est le produit scalaire des deux vecteurs. Dans la seconde illustration, ce travail est égal à - AB × AH.

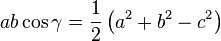

Théorème d'Al-Kashi [modifier]

Il existe une manière plus générale d'exprimer le théorème de Pythagore. Elle traite le cas d'un triangle quelconque. Avec les notations de la figure de droite, ce résultat, nommé théorème d'Al-Kashi s'exprime de la manière suivante :

ou encore

ou encore

La démonstration se trouve dans l'article détaillé. Ce résultat s'exprime en termes de produit scalaire :

- Théorème d'Al-Kashi

- Soient A, B et C trois points quelconques, alors la formule suivante est toujours vérifiée :

Le caractère plus général de cette formulation permet d'expliciter et de démontrer simplement les propriétés algébriques du produit scalaire. Le théorème de la médiane est un cas particulier explicité dans l'article à ce sujet.

Produit scalaire comme une aire [modifier]

L'expression par le produit scalaire du théorème d'Al-Kashi suggère une formulation du produit scalaire en termes d'aire. Le produit scalaire, en utilisant les notations du paragraphe sur le projeté, correspond à l'aire du rectangle de base AH et de hauteur AB.

Considérons le produit scalaire dans un plan orienté, de x vers y dans la figure de droite. Le produit scalaire des vecteurs x et y est égal à l'aire orientée du parallélogramme construit grâce aux vecteurs y et xr. Le vecteur xr est l'image du vecteur x par une rotation d'angle droit direct. Cette approche est celle de Peano. Pour ce faire, il utilise un outil appelé déterminant, et utilise la formulation suivante du produit scalaire, par construction géométrique, équivalente à celle de l'article :

Sur le dessin, les parallélogrammes ont été déformés en rectangle de même aire par la propriété de cisaillement. L'aire verte correspond à un produit scalaire positif et l'aire rose à un produit scalaire négatif.

Cette forme géométrique possède un avantage certain, elle permet d'établir les propriétés algébriques du produit scalaire. Ces propriétés sont utiles, à la fois pour établir une expression analytique utile à la résolution de nombreux problèmes et pour établir une nouvelle formulation à la fois plus générale et plus opérationnelle.

Orthogonalité, colinéarité et angle [modifier]

De telles définitions du produit scalaire donnent des outils intéressants pour vérifier une orthogonalité, une colinéarité ou déterminer un angle géométrique.

Orthogonalité : les vecteurs  et

et  sont orthogonaux si l'un ou l'autre des vecteurs est nul ou si l'angle géométrique AOB est droit. En termes de produit scalaire, cela se traduit par une seule condition

sont orthogonaux si l'un ou l'autre des vecteurs est nul ou si l'angle géométrique AOB est droit. En termes de produit scalaire, cela se traduit par une seule condition  et

et  sont orthogonaux si et seulement si

sont orthogonaux si et seulement si

Colinéarité : les vecteurs  et

et  sont colinéaires si et seulement si les points O, A et B sont sur une même droite. En termes de produit scalaire, cela se traduit par

sont colinéaires si et seulement si les points O, A et B sont sur une même droite. En termes de produit scalaire, cela se traduit par  et

et  sont colinéaires si et seulement si

sont colinéaires si et seulement si

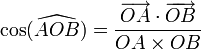

Angle géométrique : Si  et

et  sont deux vecteurs non nuls, l'angle géométrique AOB est déterminé par l'égalité

sont deux vecteurs non nuls, l'angle géométrique AOB est déterminé par l'égalité

Propriétés algébriques [modifier]

Pour une raison de simplicité, d'autres notations sont utilisées. Les vecteurs ne sont plus notés comme des bipoints, comme par exemple  mais simplement avec une lettre :

mais simplement avec une lettre :  . Le produit scalaire est alors toujours noté par un point :

. Le produit scalaire est alors toujours noté par un point :  . Il arrive aussi que les vecteurs soient notés sans flèches, pour éviter la confusion entre le produit d'un scalaire par un vecteur et le produit scalaire entre deux vecteurs, le produit scalaire est alors noté (u, v) ou encore

. Il arrive aussi que les vecteurs soient notés sans flèches, pour éviter la confusion entre le produit d'un scalaire par un vecteur et le produit scalaire entre deux vecteurs, le produit scalaire est alors noté (u, v) ou encore  . Une convention, pas toujours suivie consiste à choisir des lettres grecques pour les scalaires, permettant ainsi d'éviter des confusions. Dans la suite de l'article, la convention suivie est celle du vecteur surmonté d'une flèche et du produit scalaire noté par un point.

. Une convention, pas toujours suivie consiste à choisir des lettres grecques pour les scalaires, permettant ainsi d'éviter des confusions. Dans la suite de l'article, la convention suivie est celle du vecteur surmonté d'une flèche et du produit scalaire noté par un point.

Le terme de produit scalaire suggère l'existence d'une opération qui, à deux vecteurs, associe un scalaire. Dans un espace vectoriel, les scalaires sont les coefficients par lesquels on a le droit de multiplier les vecteurs. Dans une approche élémentaire, ces scalaires sont des réels. Le fait d'appeler cette opération un produit suggère l'existence de propriétés que l'on attend généralement d'un produit (commutativité, distributivité par rapport à l'addition...).

Symétrie [modifier]

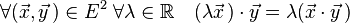

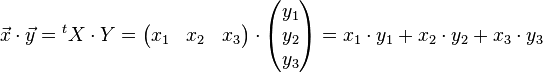

La symétrie est une propriété qui s'applique aux fonctions de deux variables prises dans un même ensemble. Soit un ensemble E et une fonction f définie dans E×E. Elle est dite symétrique si et seulement si :

Le cadre de cette définition est celui du produit scalaire, qui à deux vecteurs associe un nombre.

Comme la longueur du segment [B, C] est celle du segment [C, B], le théorème d'Al-Kashi établit la symétrie du produit scalaire :

- Symétrie du produit scalaire

- Le produit scalaire défini sur un espace vectoriel E est symétrique, c'est-à-dire que la proposition suivante est toujours vérifiée :

Bilinéarité [modifier]

Le produit scalaire dans un espace vectoriel E est compatible à droite avec l'addition. Cette propriété signifie que le produit scalaire d'un vecteur par une somme de deux vecteurs est égal à la somme des deux produits scalaires :

La figure de gauche illustre cette compatibilité. Elle est la conséquence du fait que la translation laisse invariante l'aire d'une surface. Une applicationde cette nature, laissant invariant les angles, les longueurs et par voie de conséquence les surfaces est appelée isométrie. Le rectangle vert a pour surface le produit scalaire de  avec

avec  , le rectangle bleu a pour surface le produit scalaire de

, le rectangle bleu a pour surface le produit scalaire de  avec

avec  . La somme des deux surfaces est bien égale à la surface du rectangle orange qui est le produit scalaire de

. La somme des deux surfaces est bien égale à la surface du rectangle orange qui est le produit scalaire de  avec

avec  . En effet, la translation laisse invariante la surface. L'égalité recherchée est bien vérifiée.

. En effet, la translation laisse invariante la surface. L'égalité recherchée est bien vérifiée.

La symétrie du produit scalaire ainsi que la compatibilité à droite démontre la compatibilité à gauche de l'addition :

Il est de même possible de parler de compatibilité à droite pour le produit par un scalaire. Cette propriété prend la forme suivante :

Le point désigne ici à la fois la multiplication par un scalaire et le produit scalaire. L'usage des flèches ainsi que des lettres grecques pour désigner des nombres permet d'éviter l'ambigüité.

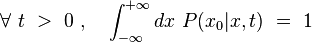

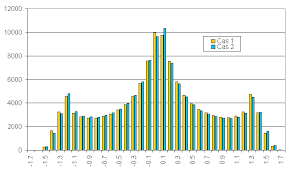

Cette compatibilité est une conséquence du théorème de Thalès. La figure de droite illustre cette propriété. Le rectangle violet possède une hauteur égale à celle du triangle vert, et sa base est égale à OD. Les deux triangles OAB et OCD sont semblables il est donc possible d' appliquer le théorème de Thalès, il démontre que comme OC = λ⋅OA, alors OD = λ⋅OB. Sa surface est donc bien multipliée par λ.

Comme précédemment, la symétrie possède pour conséquence la compatibilité à gauche :

Ainsi, l'application, pour un  qui au vecteur

qui au vecteur  associe le nombre

associe le nombre  vérifie la propriété suivante :

vérifie la propriété suivante :

On dit alors que l'application produit scalaire est linéaire à droite, elle est de même linéaire à gauche. Une telle application est dite bilinéaire. L'application a pour valeurs des nombres, on parle alors de forme.

- Bilinéarité : le produit scalaire est une forme bilinéaire.

Caractère défini positif [modifier]

Le produit scalaire d'un vecteur avec lui-même est égal à l'aire d'un carré de côté la longueur d'un de ses représentants. En conséquence, le produit scalaire d'un vecteur avec lui-même est toujours positif. Cette valeur est nulle si et seulement si le vecteur est nul car seul le vecteur nul possède un représentant de longueur nulle. On en déduit la définition et la proposition suivantes :

- Une forme à deux variables est dite définie positive si et seulement si pour tout vecteur non nul x, l'image de (x,x) est strictement positive.

- Le produit scalaire est une forme définie positive.

Bilan : produit scalaire réel [modifier]

Un produit scalaire est une forme bilinéaire symétrique définie positive sur un espace vectoriel sur les nombres réels.

Les propriétés algébriques vues dans le cas de la dimension 2 ou 3 sont suffisantes pour définir un produit scalaire dans un espace vectoriel réel quelconque.

Soit  un espace vectoriel réel.

un espace vectoriel réel.

On dit qu'une application φ :

est un produit scalaire si elle est :

-

- bilinéaire : φ est linéaire relativement à chaque argument (l'autre étant fixé).

- symétrique :

- positive :

- définie :

Il est naturel de se poser la question réciproque : Est-il possible de définir une géométrie à l'aide d'un espace vectoriel et d'un produit scalaire ? La longueur est alors donnée par la norme, et l'angle θ entre deux vecteurs  et

et  par la formule :

par la formule :

Une telle géométrie vérifie les inégalités triangulaires et de Cauchy-Schwarz, le théorème de Thalès, de Pythagore, ses isométries sont les rotations et les symétries.

Espace euclidien [modifier]

Un espace euclidien est un espace vectoriel sur  , de dimension finie et muni d'un produit scalaire.

, de dimension finie et muni d'un produit scalaire.

Un tel espace possède de nombreuses propriétés à la fois algébriques et géométriques. Le produit scalaire met en évidence des applications linéaires particulières aux propriétés multiples. Elles permettent, entre autres, de définir de nombreuses structures additionnelles, souvent elles aussi euclidiennes. Elle offre un cadre géométrique qui permet de généraliser bon nombre de résultats vrais sur les nombres réels. Il devient ainsi possible d'appliquer des résultats de l'analyse réelle à la géométrie différentielle.

Expression analytique [modifier]

Base orthonormale [modifier]

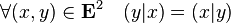

Dans un espace vectoriel de dimension deux ou trois, les propriétés algébriques permettent l'expression du produit scalaire à l'aide d'un système de coordonnées. Elle est plus simple si la base est choisie orthonormale, c'est-à-dire si ses vecteurs sont tous de norme égale à un et s'ils sont tous orthogonaux deux à deux. Par exemple en dimension trois, si la base orthonormale est notée ( ,

,  ,

,  ), si les deux vecteurs

), si les deux vecteurs  et

et  ont pour coordonnées respectives : (x1, x2, x3) et (y1, y2, y3), on obtient alors la formule :

ont pour coordonnées respectives : (x1, x2, x3) et (y1, y2, y3), on obtient alors la formule :

Elle s'obtient à partir du développement des deux vecteurs dans la base :

Avec les propriété de bilinéarité et de symétrie, on montre que :

Or  est égal à un car la base est normée et si i est différent de j alors

est égal à un car la base est normée et si i est différent de j alors  est nul car la base est orthogonale.

est nul car la base est orthogonale.

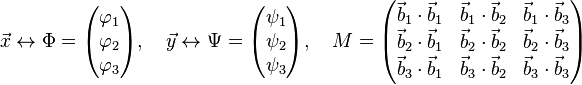

Écriture matricielle [modifier]

Il existe une manière simple d'exprimer le produit scalaire, à l'aide de matrices. Les deux vecteurs  et

et  du paragraphe précédent prennent alors la forme suivante :

du paragraphe précédent prennent alors la forme suivante :

Les matrices X et Y représentent les deux vecteurs. À l'aide de l'opération transposée et de la multiplication des matrices, on obtient l'égalité :

Base quelconque [modifier]

Si la base ( ,

,  ,

,  ) est choisie quelconque, l'expression du produit scalaire est plus complexe. Notons (φ1, φ2, φ3) et (ψ1, ψ2, ψ3) les coordonnées des vecteurs

) est choisie quelconque, l'expression du produit scalaire est plus complexe. Notons (φ1, φ2, φ3) et (ψ1, ψ2, ψ3) les coordonnées des vecteurs  et

et  dans cette nouvelle base. On a alors l'égalité :

dans cette nouvelle base. On a alors l'égalité :

La matrice M est appelée la matrice de Gram du produit scalaire dans la base ( ,

,  ,

,  ). Elle possède de nombreuses propriétés, elle est symétrique suivant une diagonale, elle est donc diagonalisable, ses valeurs propres sont toutes strictement positives. Une telle matrice est dite matrice définie positive.

). Elle possède de nombreuses propriétés, elle est symétrique suivant une diagonale, elle est donc diagonalisable, ses valeurs propres sont toutes strictement positives. Une telle matrice est dite matrice définie positive.

On montre que la donnée d'une matrice définie positive et d'une base dans un espace vectoriel réel de dimension n permettent de définir un produit scalaire de manière unique.

Généralisation aux espaces vectoriels complexes [modifier]

Produit scalaire hermitien [modifier]

Pour adapter la définition du produit scalaire réel aux espaces vectoriels complexes, nous avons besoin de la notion de « semi-linéarité » :

Une application f d'un espace vectoriel complexe  dans

dans  est dite semi-linéaire si elle vérifie :

est dite semi-linéaire si elle vérifie :

Soit donc maintenant  un espace vectoriel complexe.

un espace vectoriel complexe.

On dit qu'une application φ :

est un produit scalaire hermitien à gauche (ou simplement un produit scalaire) si elle est :

-

- sesquilinéaire à gauche : c'est-à-dire

-

- linéaire relativement au second argument (le premier étant fixé)

- semi-linéaire relativement au premier argument (le second étant fixé)

- symétrique hermitienne :

- positive :

- définie :

Remarque : la convention de linéarité à droite, semi-linéarité à gauche n'est pas universelle, certains auteurs utilisent la convention inverse. Dans un espace vectoriel complexe, muni d'un tel produit scalaire, sont encore vérifiés le théorème de Pythagore, l'inégalité de Cauchy-Schwarz et l'inégalité triangulaire.

Espace préhilbertien [modifier]

Un espace préhilbertien est un espace vectoriel réel ou complexe, généralement de dimension infinie, que l'on a muni d'un produit scalaire. La définition du produit scalaire quitte alors le champ de la géométrie traditionnelle.

Exemples [modifier]

- Dans l'espace

, on définit le produit scalaire canonique :

, on définit le produit scalaire canonique :  .

.

- Dans l'espace

, on définit le produit scalaire canonique :

, on définit le produit scalaire canonique :  .

.

- Soit

le

le  -espace vectoriel des fonctions continues de l'intervalle

-espace vectoriel des fonctions continues de l'intervalle ![[a,, b]](http://upload.wikimedia.org/math/d/2/5/d2524b9940ce1c636bfb26ae09a941d2.png) dans

dans  .

.

- L'application

est un produit scalaire sur E.

est un produit scalaire sur E.

- Soit

![E=C([a,, b],mathbb{C})](http://upload.wikimedia.org/math/6/a/1/6a1ecef636c975ee4b38c1f179f891a9.png) le

le  -espace vectoriel des fonctions continues de l'intervalle

-espace vectoriel des fonctions continues de l'intervalle ![[a,, b]](http://upload.wikimedia.org/math/d/2/5/d2524b9940ce1c636bfb26ae09a941d2.png) dans

dans  ,

,

- L'application :

est un produit scalaire sur

est un produit scalaire sur  .

. - Remarque : Si , au lieu de travailler sur des fonctions continues, on travaille sur des fonctions continues par morceaux, la forme bilinéaire construite est bien positive mais n'est pas définie : (f|f) = 0 implique que f est nulle sauf sur un nombre fini de points.

Espace hermitien [modifier]

Un espace hermitien est un espace vectoriel défini sur les nombres complexes, de dimension finie et disposant d'un produit hermitien, correspondant à une généralisation du cas réel. Le terme de produit scalaire est aussi utilisé dans ce contexte. Les résultats et propriétés des espaces euclidiens se traduisent souvent simplement dans cet espace.

Espace de Hilbert [modifier]

Un espace de Hilbert peut être réel ou complexe. Il correspond exactement aux deux cas précédents, à la différence que la dimension n'est pas nécessairement finie. Si la théorie et les démonstrations sont différentes de la situation en dimension finie, certains résultats se généralisent. Une hypothèse topologique est néanmoins souvent nécessaire, celle de lacomplétude de l'espace métrique associé. Pour cette raison, un espace de Hilbert est par définition complet.

Cet espace est utilisé pour résoudre des problèmes d'analyse fonctionnelle, particulièrement des équations aux dérivées partielles.

Voir aussi [modifier]

Articles connexes [modifier]

- Orthogonalité

- Projection orthogonale

- Espace de Hilbert

- Espace quadratique

- Groupe orthogonal

- Mesures secondaires

Sources [modifier]

- Rudolf Bkouche, D'où vient le produit scalaire ?, site de l'ENS

10:04 Publié dans Produit scalaire | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

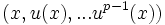

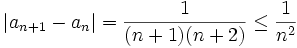

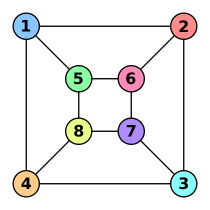

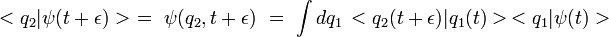

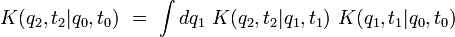

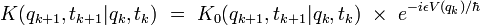

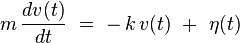

Polynômes - Equations de degré 3

Polynômes - Equations de degré 3

(x - a)(ax² + bx + c = 0)

![]()

On pourra revoir les chapitres Signe de ax + b et Signe de ax² + bx + c

| Source : | http://www.vivelesmaths.com/ |

|

10:00 Publié dans Polynômes - Equations de degré 3 | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

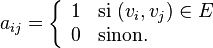

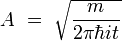

Endomorphisme nilpotent

Source : http://fr.wikipedia.org/wiki/Endomorphisme_nilpotent

Endomorphisme nilpotent

Un endomorphisme nilpotent est un morphisme d'un objet mathématique sur lui-même, qui, composé par lui-même un nombre suffisant de fois, donne le morphisme nul. C’est donc (lorsque les endomorphismes de cet objet forment un anneau) un élément nilpotentde cet anneau.

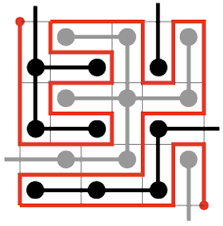

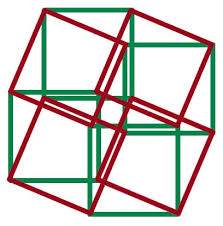

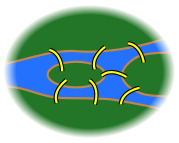

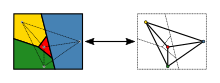

En algèbre linéaire, on considère les endomorphismes nilpotents d’un espace vectoriel. Un exemple est donné dans l'illustration. Ils interviennent dans la réduction des endomorphismes, c’est-à-dire la représentation d'un endomorphisme quelconque sous une forme la plus simple possible. Cette réduction sert par exemple pour la résolution d'équations différentielles linéaires.

On retrouve également le concept de nilpotence dans l'étude des groupe de Lie, avec l'analyse des algèbres de Lie nilpotentes.

Les endomorphismes nilpotents d'un espace vectoriel sont l'objet principal de cet article. Lorsque de plus cet espace est de dimension finie, chacun de ses endomorphismes est représenté par une matrice (dans une base de l'espace vectoriel concerné). L'endomorphisme est alors nilpotent si et seulement s'il a une matrice nilpotente, ce qui, par le calcul, permet une approche plus concrète du concept (toutes les propriétés générales des endomorphismes nilpotents ont leur pendant dans le contexte plus particulier des matrices nilpotentes), et offre d'importantes applications pratiques.

Sommaire[masquer] |

Définition [modifier]

Soit E un espace vectoriel sur un corps K et u un endomorphisme de E. L'endomorphisme u est dit nilpotent si et seulement s'il existe un entier n>0 tel que un = 0. Le plus petit entier naturel n vérifiant cette propriété est alors appelé indice (de nilpotence) de l'endomorphisme u.

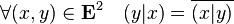

Soit x un vecteur de E, on appelle indice de x (pour l'endomorphisme nilpotent u) le plus petit entier naturel p tel que up(x) = 0.

Un sous-espace cyclique de E (pour l'endomorphisme nilpotent u) est un sous-espace vectoriel de E engendré par une famille de la forme (x, u(x), u2(x), ..., up-1(x)), où x est un vecteur d'indice p.

Intérêt du concept [modifier]

Nilpotence et réduction [modifier]

Un enjeu important en mathématique est celui de la réduction, c’est-à-dire de la décomposition d'un concept en sous-concepts plus simples et qui décrivent l'intégralité du concept initial. Dans le cadre des applications linéaires la réduction est traitée dans l'article Réduction d'endomorphisme. En dimension finie, les endomorphismes nilpotents jouent un rôle important dans le cas ou  est un corps algébriquement clos. Un corps est dit algébriquement clos si et seulement si tous les polynômes sont scindés, autrement dit si tous les polynômes s'écrivent comme produit de polynômes du premier degré. C'est par exemple le cas pour les nombres complexes. Sous cette hypothèse, la théorie de la réduction d'endomorphisme montre que le cas général se résume à la somme d'un endomorphisme diagonalisable et d'un nilpotent. Ce résultat est connu sous le nom de Décomposition de Dunford.

est un corps algébriquement clos. Un corps est dit algébriquement clos si et seulement si tous les polynômes sont scindés, autrement dit si tous les polynômes s'écrivent comme produit de polynômes du premier degré. C'est par exemple le cas pour les nombres complexes. Sous cette hypothèse, la théorie de la réduction d'endomorphisme montre que le cas général se résume à la somme d'un endomorphisme diagonalisable et d'un nilpotent. Ce résultat est connu sous le nom de Décomposition de Dunford.

Si le corps n'est pas algébriquement clos, alors il est toujours possible d'étendre l'espace vectoriel sur un corps algébriquement clos. Cette technique est largement utilisée. Pour lesréels, la physique n'utilise pratiquement que cette approche.

Applications [modifier]

Puisqu'il est possible d'étendre à la clôture algébrique, la réduction des endomorphismes dans ce contexte joue un rôle essentiel en mathématique. Les endomorphismes nilpotents sont donc nécessaires à divers branches des mathématiques. En algèbre linéaire, ils interviennent naturellement dans la réduction de Jordan qui correspond à un cas important de réduction des endomorphismes. Les techniques utilisées sont celles des polynômes d'endomorphismes. Les conséquences se retrouvent sur la résolution de systèmes d'équations linéaires, dans la résolution d'équations différentielles linéaires où ils apparaissent comme des cas limites. En mathématiques appliquées, ils sont importants pour la recherche d'algorithmes, on utilise alors essentiellement les matrices nilpotentes où des représentations simples sont alors nécessaires.

Propriétés [modifier]

L'exemple illustre l'essentiel des propriétés des endomorphismes nilpotents. On y trouve des propriétés sur l'indice des endomorphismes et des vecteurs, des conditions nécessaires et suffisantes grâce aux polynômes. Des réductions avec une décomposition en espaces propres et l'existence d'une base réduite. Il existe aussi des propriétés calculatoires des matrices nilpotentes traitées dans l'article Matrice nilpotente.

Nilpotence et indice [modifier]

L'indice d'un endomorphisme nilpotent possède deux grandes propriétés :

-

- L'indice d'un endomorphisme nilpotent est inférieur ou égal à la dimension de l'espace (pour la démonstration penser à utiliser la suite (kerfn)).

- Il existe un vecteur dont l'indice est celui de l'endomorphisme.

Nilpotence et polynômes en dimension finie [modifier]

Les polynômes fournissent non seulement des conditions nécessaires et suffisantes pour la nilpotence, mais renseignent de plus sur l'indice.

-

- Un endomorphisme est nilpotent si et seulement si son polynôme caractéristique est égal à ( − X)n ou n est la dimension de l'espace.

- Un endomorphisme est nilpotent si et seulement si son polynôme minimal est égal à Xp ou p est l'indice de l'endomorphisme.

- Le polynôme minimal d'un vecteur x est égal à

ou px est l'indice du vecteur x.

ou px est l'indice du vecteur x.

Nilpotence et réduction en dimension finie [modifier]

Le principe de réduction consiste à trouver une décomposition en somme directe de sous-espaces stables de l'espace vectoriel. Il en existe une pour les endomorphismes nilpotents. Et elle est compatible avec la réduction de Jordan. Cette approche est générale à l'analyse des endomorphismes. Dans le cas des endomorphismes nilpotents, elle est intimement liée à la notion de base réduite. Tout endomorphisme nilpotent u d'un espace vectoriel E non réduit au vecteur nul vérifie les propriétés suivantes :

-

- Si

est un vecteur d'indice p alors la famille

est un vecteur d'indice p alors la famille  est libre. C'est donc une base du sous-espace cyclique qu'elle engendre.

est libre. C'est donc une base du sous-espace cyclique qu'elle engendre. - Pour tout sous-espace stable F de E (en particulier pour tout sous-espace cyclique), l'endomorphisme de F obtenu par restriction de u est, lui aussi, nilpotent (donc vérifie toutes les propriétés de cette liste, dès que F n'est pas réduit au vecteur nul).

- u possède une unique valeur propre : 0 (en particulier, son noyau n'est pas réduit au vecteur nul).

- E est somme directe de sous-espaces cycliques non réduits au vecteur nul.

- Une telle décomposition est "maximale", au sens où toute autre décomposition de E en somme directe de sous-espaces stables non réduits au vecteur nul est constituée d'au plus autant de sous-espaces.

- Si

Applications en mathématiques [modifier]

Matrice nilpotente [modifier]

Les résultats théoriques obtenus à l'aide de l'analyse des endomorphismes nilpotents ont des conséquences importantes sur les matrices nilpotentes. Ces résultats sont traités dans l'article Matrice nilpotente.

Réduction des endomorphismes [modifier]

Dans le cas où le corps est algébriquement clos et en dimension finie, les endomorphismes nilpotents jouent un rôle particulier dans la problématique de la réduction des endomorphismes. Le cas général, celui où toutes les racines du polynôme minimal sont simples, correspond aux endomorphismes diagonalisables. Ce cas génère un ensemble d'endomorphismes partout dense. En revanche, en cas de racine multiple, alors il existe une composante nilpotente.

Cette décomposition joue un rôle important dans les calculs que l'on observe dans l'univers des matrices. Elle permet par exemple de prouver que toute matrice est trigonalisable et offre une forme particulièrement simple en bloc de Jordan.

De nombreux algorithmes relèvent directement de cette décomposition. Elle permet d'accélérer massivement la résolution d'un système d'équations linéaires.

Équation différentielle linéaire [modifier]

La réduction de Jordan joue un rôle particulier pour les équations différentielles linéaires. Par exemple, dans le cas où les coefficients sont constants, alors le calcul de l'exponentielle d'une matrice dans le cas général est largement plus simple dans le cas d'une représentation matricielle réduite par la méthode de Jordan. Il est alors important de pouvoir calculer l'exponentielle d'une matrice nilpotente. Ce cas est exposé dans l'article Matrice nilpotente.

Groupes de Lie [modifier]

Dans l'étude des groupes de Lie, on s'intéresse parfois à ce que l'on appelle groupes de Lie nilpotents. Comme pour tout groupe de Lie, leur structure est décrite par leur fibré tangent, qui est muni d'une structure d'algèbre de Lie. Les représentations de ces algèbres dans les endomorphismes s'obtiennent à partir d'endomorphismes nilpotents.

Sources [modifier]

Liens internes [modifier]

principaux articles utilisés pour les démonstrations

Principaux articles utilisant la notion d'endomorphisme nilpotent

09:58 Publié dans Endomorphisme nilpotent | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

Réduction d'endomorphisme

Source : http://fr.wikipedia.org/wiki/R%C3%A9duction_des_endomorph...

Réduction d'endomorphisme

En mathématiques, et plus particulièrement en algèbre linéaire, la réduction d'endomorphisme est une technique mathématique qui a pour objectif d'exprimer des matrices et desendomorphismes sous une forme plus simple, notamment pour faciliter les calculs. Cela consiste essentiellement à trouver une base de l'espace vectoriel qui permet d'exprimer plus simplement l'endomorphisme dans cette nouvelle base, et à décomposer l'espace en sous-espace vectoriels stables par l'endomorphisme.

Motivation [modifier]

Le concept de réduction [modifier]

La technique de réduction en algèbre est fréquente, elle consiste à réduire un concept, en sous-concepts les plus simples possible et permettant de reconstruire le cas général. Dans le cas des endomorphismes (c’est-à-dire des applications linéaires d'un espace vectoriel dans lui-même) la technique consiste à décomposer l'espace vectoriel en espaces plus petits. Cette réduction doit posséder six propriétés :

- L'endomorphisme définit par restriction un nouvel endomorphisme sur chacun des sous-espaces (c'est-à-dire chacun est un sous-espace vectoriel stable), ainsi la petite structure est une entité intrinsèque avec sa propre cohérence.

- Les différents sous-espaces sont en somme directe, c'est à dire indépendants les uns des autres. En conséquence, l'intersection de deux de ces sous-espaces est toujours réduite au vecteur nul.

- Les différents sous-espaces engendrent l'espace entier (ils sont supplémentaires), ce qui offre l'exhaustivité de l'analyse.

- La réduction décrit l'intégralité de la structure originelle.

- Elle est maximale, c'est-à-dire qu'il n'existe pas de décomposition en éléments plus petits et donc plus simple.

- Elle est aussi simple que possible, c'est-à-dire que pour chacune des sous-structures il n'existe pas de représentation plus élémentaire.

Toutefois, elle n'est pas unique.

Endomorphisme et vecteur propre [modifier]

La structure d'espace vectoriel sur lequel s'applique l'endomorphisme possède des propriétés différentes selon les cas. Dans l'hypothèse où la dimension est finie, alors la structure ducorps détermine l'essentiel des propriétés de réduction. Une approche très générale, pour établir la relation entre la structure du corps et la réduction des endomorphismes consiste à analyser la structure de l'anneau des polynômes associée au corps. Cette approche est analysée dans l'article polynôme d'endomorphisme. Le cas le plus simple est celui où le corps est dit algébriquement clos, c'est-à-dire que tout polynôme admet au moins une racine. C'est le cas des nombres complexes. Alors la réduction est particulièrement efficace. La notion de valeur propre devient le bon outil dans ce contexte. Lorsqu'il existe une base de vecteurs propres, on parle de diagonalisation. Tout endomorphisme n'est pas diagonalisable, en revanche sur un espace vectoriel réel ou complexe de dimension finie, les endomorphismes diagonalisables sont denses topologiquement.

Réduction de Jordan [modifier]

Il y a 2 obstacles qui empêchent que tout endomorphisme soit diagonalisable. Le premier est constitué des endomorphismes nilpotents ; il a été analysé par le mathématicien Camille Jordan. On montre que tout endomorphisme en dimension finie sur un corps algébriquement clos se décompose en sous-espaces caractéristiques où l'endomorphisme est la somme d'une homothétie et d'un endomorphisme nilpotent.

Le deuxième obstacle apparaît lorsque l'espace vectoriel n'est pas sur un corps algébriquement clos, comme les nombres réels par exemple. Dans ce cas les polynômes caractéristique et minimal peuvent avoir des facteurs premiers de degré supérieur ou égal à 2. Pour ces facteurs de plus haut degré, le concept de valeur propre doit être généralisé en celui de chaîne de Jordan. On dit qu'un polynôme P de degré d est une chaîne de Jordan d'un endomorphisme u si

- il existe un vecteur x non nul tel que P(u)(x)=0 ;

- la famille

est libre.

est libre.

L'intérêt de cette notion est que la famille (x,...,ud-1(x)) engendre un sous-espace vectoriel stable par u, sur lequel la matrice de u est la matrice compagnon de Jordan de P.

Quand le degré d vaut 1, on retrouve la définition de valeur propre usuelle. On peut montrer que tout facteur premier du polynôme minimal d'un endomorphisme est une chaîne de Jordan de cet endomorphisme. Par conséquent tout endomorphisme admet une base où sa matrice a une diagonale formée de blocs matrices compagnons et de moitié inférieure gauche nulle (c'est donc une matrice presque triangulaire supérieure).

Endomorphisme et distance [modifier]

Il existe un cas particulier d'espace vectoriel : ceux qui sont munis d'une distance compatible avec la structure vectorielle. Un cas important est celui où la distance est euclidienne (ou hermitienne dans le cas complexe). L'ajout de cette structure offre une nouvelle voie d'accès à la problématique de la réduction d'endomorphisme. S'il est compatible avec la distance, c'est-à-dire s'il est normal, alors une nouvelle approche est possible. Dans ce contexte, l'exception nilpotente est absente. La réduction est plus simple et les techniques algorithmiques associées plus rapides.

Analyse fonctionnelle et opérateur linéaire [modifier]

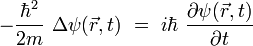

Ce cas guide Hilbert dans une nouvelle direction. La généralisation de l'approche aux opérateurs différentiels. Ces opérateurs comme le laplacien ou le d'alembertien sont la clé d'importants problèmes en physique. Ils peuvent se représenter comme une équation linéaire, mais dans un espace de dimension infinie. Si l'approche générale de Jordan est vouée à l'échec car les polynômes ne s'appliquent pas dans ce contexte, en revanche ces opérateurs présentent les bonnes propriétés de compatibilité vis-à-vis d'une distance qu'il est possible de définir sur l'espace. Hilbert, propose une approche novatrice, consistant à étudier les propriétés géométriques de ces espaces de dimension infinie, au lieu de se limiter à une analyse d'un point particulier : la fonction solution de l'équation. Cette approche ouvre une nouvelle branche des mathématiques devenue essentielle au siècle dernier: l'analyse fonctionnelle. La physique moderne, aussi bien sous sa forme quantique que sous sa forme relativiste, utilise largement cette vision des choses.

Histoire [modifier]

Cas général de la dimension finie [modifier]

Dans toute cette section, E désigne un espace vectoriel sur un corps K, et sa dimension, supposée finie, est notée n.

Réduction et sous-espaces propres [modifier]

Il existe un premier candidat naturel pour une réduction, elle correspond à une décomposition en sous-espaces propres. Une présentation complète du concept est proposé dans l'article détaillé.

Un vecteur propre est un vecteur non nul dont l'image par u est colinéaire au vecteur d'origine. Le rapport de colinéarité est appelé valeur propre. L'ensemble des vecteurs propres pour une valeur propre donnée associée au vecteur nul forme un sous-espace vectoriel appelé sous-espace propre.

Une décomposition en sous-espaces propres représente donc un grand nombre des propriétés recherchées pour une réduction.

- Les espaces propres sont stables par l'endomorphisme.

- L'intersection de deux sous-espaces propres est réduite au vecteur nul.

- La restriction de l'endomorphisme à un sous-espace propre est une homothétie, c'est-à-dire une application qui à un vecteur x associe le vecteur λ.x.

Les propriétés recherchées dans la réduction sont presque rassemblées.

Diagonalisation [modifier]

Il suffirait en effet d'une propriété supplémentaire pour permettre une réduction à l'aide de cette approche : que la somme directe des sous-espaces propres soit l'espace vectoriel entier. Cela équivaut à l'existence d'une base B de vecteurs propres. Les deux propriétés manquantes sont alors réunies, car la réduction est composée de sous-espaces de dimension 1, ceux qui sont engendrés par les vecteurs de la base. Cette décomposition est maximale car il n'existe pas de décomposition en somme directe de sous-espaces non réduits au vecteur nul qui contiennent plus de sous-espaces que la dimension de l'espace.

Le fait que B soit une base garantit que la décomposition engendre bien l'espace entier.

En termes plus formels, les trois propositions suivantes sont équivalentes. Elles fournissent la définition d'un premier cas de réduction pour u.

-

- u est diagonalisable.

- Il existe une base de vecteurs propres.

- La somme des dimensions des sous-espaces propres est égale à la dimension de l'espace entier.

- La somme des sous-espaces propres est l'espace entier.

- Toute représentation matricielle de u est diagonalisable.

Une démonstration se trouve dans l'article Diagonalisation, sauf pour la dernière équivalence qui est traitée dans Matrice diagonale.

Diagonalisation et polynôme caractéristique [modifier]

Il existe d'autres propriétés importantes associées à cette définition. Elles proviennent essentiellement d'une approche polynomiale sur l'endomorphisme. Le polynôme caractéristique deu est, en dimension finie, un outil puissant d'analyse des endomorphismes. Il est défini comme le déterminant suivant : det(u -λ.I ). Comme le déterminant s'annule si et seulement si le noyau de l'application linéaire associée n'est pas réduit au vecteur nul, le polynôme possède comme racines les valeurs propres de l'endomorphisme. Trois propriétés relient diagonalisabilité et polynôme caractéristique.

-

- Si le polynôme caractéristique de u possède n racines distinctes alors u est diagonalisable.

C'est une condition suffisante, mais non nécessaire. Considérons le cas d'une homothétie dans le cas où n est strictement supérieur à 1. Le polynôme caractéristique ne possède qu'une racine multiple. Pourtant l'endomorphisme est clairement diagonalisable car toute base est constituée de vecteurs propres uniquement. Il existe de plus la condition nécessaire suivante :

-

- Si u est diagonalisable, alors son polynôme caractéristique est scindé.

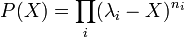

Dire que le polynôme caractéristique P(X) est scindé signifie qu'il peut s'écrire comme produit de puissances de polynômes de degré 1 :

Pour l'obtention d'une condition nécessaire et suffisante à partir du polynôme caractéristique, une définition supplémentaire est nécessaire.

-

- la multiplicité algébrique d'une valeur propre est son ordre de multiplicité en tant que racine du polynôme caractéristique.

La multiplicité algébrique d'une valeur propre λ est donc l'exposant du polynôme (X-λ) dans le polynôme caractéristique. Cette définition permet de formuler une condition nécessaire et suffisante de diagonalisabilité.

-

- u est diagonalisable si et seulement si tout sous-espace propre possède une dimension égale à la multiplicité algébrique de la valeur propre associée.

Endomorphisme diagonalisable et polynôme minimal [modifier]

Si l'approche par le polynôme caractéristique offre des premiers résultats, elle n'est néanmoins pas intégralement satisfaisante. En effet, le calcul du polynôme est souvent lourd, et la recherche de la dimension des sous-espaces propres n'est pas simple.

Le concept de polynôme d'endomorphisme propose un autre candidat, souvent plus pertinent pour l'analyse des applications linéaires en dimension finie. C'est le polynôme minimal. À l'instar du polynôme caractéristique, ses racines sont aussi les valeurs propres. Sa spécificité s'exprime dans la condition nécessaire et suffisante suivante :

-

- u est diagonalisable si et seulement si son polynôme minimal est scindé sur K et à racines simples.

Cas où le polynôme minimal est scindé [modifier]

Réduction et endomorphisme nilpotent [modifier]

Même dans le cas où le polynôme minimal est scindé, il existe au moins un cas où la diagonalisation est impossible, celui des endomorphismes nilpotents. L'unique valeur propre est 0, donc l'unique sous-espace propre est son noyau. En conséquence le seul endomorphisme nilpotent diagonalisable est l'endomorphisme nul.

Les endomorphismes nilpotents disposent néanmoins d'une réduction traitée et démontrée dans l'article Endomorphisme nilpotent dans le paragraphe nilpotence et réduction en dimension finie. Un sous-espace cyclique de E (pour l'endomorphisme nilpotent u) est un sous-espace vectoriel engendré par une famille de la forme (x, u(x), u2(x), ...).

-

- Si u est nilpotent alors E est somme directe de sous-espaces cycliques pour u.

Nous y trouvons bien toutes les caractéristiques d'une réduction, une décomposition en somme directe de sous-espaces stables qui engendre l'espace entier. Dans l'article détaillé on montre de plus que cette décomposition est maximale.

Décomposition de Dunford [modifier]

Si le cas des endomorphismes nilpotents apparaît dans un premier temps comme une exception au cas diagonalisable, la théorie des polynômes d'endomorphismes nous montre que cette exception est unique. Plus précisément, la proposition suivante, connue sous le nom de décomposition de Dunford est vraie :

-

- Si le polynôme minimal de u est scindé alors u est la somme d'un endomorphisme diagonalisable et d'un endomorphisme nilpotent qui commutent entre eux.

Dans le contexte du théorème, le polynôme minimal  s'écrit sous la forme suivante :

s'écrit sous la forme suivante :

Les noyaux  sont appelés les sous-espaces de E caractéristiques de u.

sont appelés les sous-espaces de E caractéristiques de u.

Les quatre propriétés suivantes résument l'essentiel des propriétés associées à la décomposition de Dunford :

-

- Les λi sont les valeurs propres de u.

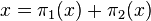

- L'espace E est somme directe des sous-espaces caractéristiques.

- Les sous-espaces caractéristiques sont stables par u. La restriction de u à

est la somme d'une homothétie de rapport

est la somme d'une homothétie de rapport  et d'un endomorphisme nilpotent d'ordre

et d'un endomorphisme nilpotent d'ordre  .

. - Les projecteurs sur les sous-espaces caractéristiques s'expriment sous forme de polynômes d'endomorphisme de u.

L'hypothèse que le polynôme minimal soit scindé représente une contrainte souvent faible. Le fait que les nombres complexes forment un corps algébriquement clos garantit déjà la généralité de la condition. Pour le cas des nombres réels, il est toujours possible d'étendre l'espace vectoriel aux corps des complexes pour la recherche des solutions, puis dans un deuxième temps de ne choisir que des solutions réelles. Pour les applications, cette démarche est souvent utilisée par les physiciens.

Réduction de Jordan [modifier]

La décomposition de Dunford n'est néanmoins pas une réduction. En effet, cette décomposition n'est pas maximale. Un sous-espace caractéristique se décompose encore.

Sur un sous-espace caractéristique Ei, la restriction de l'endomorphisme s'exprime comme la somme d'une homothétie et d'un endomorphisme nilpotent. En réduisant cet endomorphisme nilpotent comme indiqué précédemment, on décompose Ei en sous-espaces (stables par l'homothétie). La réduction des endomorphismes nilpotents fournit ainsi une décomposition maximale en sous-espaces stables à l'aide de la définition des espaces de Jordan.

-

- Un sous-espace de Jordan pour u est un sous-espace vectoriel de E possédant une base (e1, e2, ... , ep) telle que :

![exists lambdain K ;forall i in [1,p-1]; u(e_i)=lambda e_i + e_{i+1}quad et quad u(e_p)=lambda e_p](http://upload.wikimedia.org/math/d/2/5/d2598a5b960dfe353326272a37107de2.png)

Cette définition nous permet alors de décrire une réduction de Jordan pour u :

-

- Si le polynôme minimal de u est scindé alors E est somme directe de sous-espaces de Jordan, et il n'existe aucune décomposition de E en somme directe de sous-espaces, stables par u et non réduits au vecteur nul, comportant plus de composantes qu'une décomposition de Jordan.

Cas du corps des réels [modifier]

Comme pour un corps quelconque, on peut complexifier ou utiliser la décomposition de Frobenius.

Cas d'un corps quelconque [modifier]

La décomposition de Frobenius est la plus adaptée lorsqu'on ne veut pas travailler sur un corps algébriquement clos.

Une autre approche possible consiste à plonger le corps K dans sa clôture algébrique  puis le cas-espace E dans le produit tensoriel

puis le cas-espace E dans le produit tensoriel  . Un endomorphisme de E se prolonge alors de façon unique à

. Un endomorphisme de E se prolonge alors de façon unique à  . Le point de vue matriciel est alors avantageux puisqu'on conserve la même matrice pour l'endomorphisme initial ou son prolongement, elle est simplement considérée comme matrice de

. Le point de vue matriciel est alors avantageux puisqu'on conserve la même matrice pour l'endomorphisme initial ou son prolongement, elle est simplement considérée comme matrice de  .

.

Utilisation de la réduction en dimension finie [modifier]

La diagonalisation est souvent la meilleure approche pour les problèmes concrets. Les matrices diagonalisables étant dense dans l'ensemble des matrices à coefficients complexes, l'imprécision des données initiales fait qu'une matrice correspondant à un problème réel est toujours diagonalisable.

En statistique, la diagonalisation permet de faire une analyse en composante principale.

La réduction des matrices (diagonalisation ou réduction de Jordan) permette un calcul des puissances de cette matrice ainsi que de son exponentielle. Par ailleurs, le calcul de exp(tA)est particulièrement utile pour résoudre les systèmes différentiels linéaires à coefficients constants.

Réduction et forme bilinéaire en dimension finie [modifier]

Les matrices symétriques réelles (qui représentent des formes bilinéaires symétriques réelles) sont diagonalisables en base orthonormée.

Réduction et analyse fonctionnelle [modifier]

09:57 Publié dans Réduction d'endomorphisme | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

Lemme des noyaux

Source : http://fr.wikipedia.org/wiki/Lemme_des_noyaux

Lemme des noyaux

En algèbre linéaire, le lemme des noyaux est un résultat sur la réduction des endomorphismes. Dans un espace vectoriel E sur un corps K, si un opérateur u de E est annulé par un polynôme P(X) à coefficients dans K, alors ce lemme prévoit une décomposition de E comme somme directe de sous-espaces vectoriels stables par u. Ces derniers se définissent comme noyaux de polynômes en u, les projecteurs associés étant eux-mêmes des polynômes en u.

La démonstration traduit l'identité de Bezout portant sur les polynômes à des sous-espaces vectoriels. Résultat fondamental, le lemme des noyaux conduit à la décomposition de Dunford puis à la décomposition de Jordan. Plus modestement, le lemme des noyaux montre qu'un opérateur u est diagonalisable s'il est annulé par un polynôme à racines simples.

Sommaire[masquer] |

Enoncé [modifier]

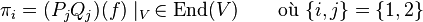

Lemme des noyaux — Soit E un espace vectoriel sur un corps K et soit f un endomorphisme de E. Si ![P_1,ldots,P_n in K[X]](http://upload.wikimedia.org/math/1/9/2/192527f1c86d44ab5e67ee58757eb75c.png) (avec

(avec  ) sont premiers entre eux deux à deux, alors les sous-espaces vectoriels Vi = ker(Pi(f)) (où

) sont premiers entre eux deux à deux, alors les sous-espaces vectoriels Vi = ker(Pi(f)) (où  ) sont en somme directe et

) sont en somme directe et

De plus, la projection sur Vi parallèlement à  est Qi(f) pour un polynôme Qi.

est Qi(f) pour un polynôme Qi.

Démonstration [modifier]

Réduction au cas n = 2 [modifier]

On montre d'abord par récurrence sur n que si le lemme est vrai pour n = 2, il est vrai pour tout n. Il n'y a rien à montrer pour le cas n = 1 (la projection mentionnée est l'identité, qui estQ(f) avec Q le polynôme constant 1). Si n > 2 on pose  alors

alors  et Q est premier avec Pn (car d'après le théorème de Bachet-Bézoutchacun des facteurs Pi de Q est inversible modulo Pn, et leur produit Q l'est donc aussi). Alors le cas n = 2 dit que

et Q est premier avec Pn (car d'après le théorème de Bachet-Bézoutchacun des facteurs Pi de Q est inversible modulo Pn, et leur produit Q l'est donc aussi). Alors le cas n = 2 dit que  , avec les projections correspondantes données par des polynômes en l'endomorphisme f; l'hypothèse de récurrence permet de décomposer

, avec les projections correspondantes données par des polynômes en l'endomorphisme f; l'hypothèse de récurrence permet de décomposer  commer somme directe des

commer somme directe des  pour

pour  , et les projections de

, et les projections de  sur ces facteurs se composent avec celle sur

sur ces facteurs se composent avec celle sur  pour donner des projections requises

pour donner des projections requises  .

.

Le cas n = 2 [modifier]

On voit sans problème que l'espace V = ker(P1P2)(f) contient les espaces  pour i = 1,2, et donc aussi leur somme; il s'agit de montrer que la somme V1 + V2 est directe et égale à V tout entier (avec des projections polynômes en

pour i = 1,2, et donc aussi leur somme; il s'agit de montrer que la somme V1 + V2 est directe et égale à V tout entier (avec des projections polynômes en  ). D'après le théorème de Bachet-Bézout, il existe

). D'après le théorème de Bachet-Bézout, il existe ![Q_1,Q_2 in K[X]](http://upload.wikimedia.org/math/2/1/3/213ec71c5566f54610e89067d66f8792.png) tel que P1Q1 + P2Q2 = 1, et par conséquent (P1Q1 + P2Q2)(f) = idE (l'application identité de E). Notons

tel que P1Q1 + P2Q2 = 1, et par conséquent (P1Q1 + P2Q2)(f) = idE (l'application identité de E). Notons

,

,

donc  et

et  .

.

Pour voir que la somme V1 + V2 est directe, on considère  . On a

. On a  , et la somme est directe.

, et la somme est directe.

Pour voir que V1 + V2 = V on considère  . On a

. On a  avec

avec  car

car

,

,

et on a  pour des raisons similaires. On conclut que

pour des raisons similaires. On conclut que  et donc V = V1 + V2.

et donc V = V1 + V2.

Finalement, les projections de  sur les facteurs sont

sur les facteurs sont  et

et  : on a déjà vu que l'image de

: on a déjà vu que l'image de  est contenue dans Vi, et qu'il s'annule sur l'autre facteur, donc il reste à voir que

est contenue dans Vi, et qu'il s'annule sur l'autre facteur, donc il reste à voir que  est l'identité sur Vi. Pour

est l'identité sur Vi. Pour  on a

on a  , donc c'est vérifié.

, donc c'est vérifié.

Applications [modifier]

Le lemme des noyaux sert pour la réduction des endomorphismes. Par exemple :

Réduction à une forme diagonale par blocs — Soit E un espace vectoriel de dimension finie sur un corps K et soit f un endomorphisme de E. Soit ![Pin K[X]](http://upload.wikimedia.org/math/4/f/a/4facb36da11821b818abd66b424a6a76.png) unpolynôme annulateur de f (par exemple son polynôme minimal, ou son polynôme caractéristique d'après le théorème de Cayley-Hamilton) et

unpolynôme annulateur de f (par exemple son polynôme minimal, ou son polynôme caractéristique d'après le théorème de Cayley-Hamilton) et  la factorisation de Pavec les polynômes Pi irréductibles et distincts. Alors il existe une base

la factorisation de Pavec les polynômes Pi irréductibles et distincts. Alors il existe une base  de E et des matrices

de E et des matrices  telles que

telles que

où  (en fait la partie de

(en fait la partie de  correspondant au bloc Ai est une base de

correspondant au bloc Ai est une base de  ), et

), et  .

.

09:56 Publié dans Lemme des noyaux | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

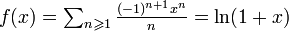

Théorème d'Abel (analyse)

Source : http://fr.wikipedia.org/wiki/Th%C3%A9or%C3%A8me_d'Abel_(a...

Théorème d'Abel (analyse)

Le théorème d'Abel, ou théorème de convergence radiale d'Abel, est un outil central de l'étude des séries entières.

Théorème — Soit  une série entière (à coefficients complexes) de rayon de convergence égal à R.

une série entière (à coefficients complexes) de rayon de convergence égal à R.

Si  converge, alors :

converge, alors :

.

.Remarque : dans le cas où la série  est absolument convergente, le résultat est trivial, il n'y a donc pas lieu d'invoquer ce théorème.

est absolument convergente, le résultat est trivial, il n'y a donc pas lieu d'invoquer ce théorème.

En effet, sous cette condition,  converge normalement donc uniformément sur [0, R] ; on retrouve immédiatement :

converge normalement donc uniformément sur [0, R] ; on retrouve immédiatement :

. Encore par le critère de convergence des séries alternées, on peut affirmer que

. Encore par le critère de convergence des séries alternées, on peut affirmer que  converge, d'où :

converge, d'où :

09:54 Publié dans Théorème d'Abel (analyse) | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

Sommation par parties

Source : http://fr.wikipedia.org/wiki/Lemme_d'Abel

Sommation par parties

La sommation par parties est l'équivalent pour les séries de l'intégration par parties. On l'appelle également transformation d'Abel ou sommation d'Abel ou lemme d'Abel.

Sommaire[masquer] |

Énoncé [modifier]

Soient deux suites  et

et  . Si l'on pose

. Si l'on pose

alors

Cette opération, qui transforme l'expression de la série à étudier, est utile pour prouver certains critères de convergence de SN.

Similitude avec l'intégration par parties [modifier]

La formule de l'intégration s'écrit : ![int_a^b f(x) g'(x),dx = left[ f(x) g(x) right]_{a}^{b} - int_a^b f'(x) g(x),dx](http://upload.wikimedia.org/math/0/c/c/0cc4450e2b913b0d32c34fac3ec1aea3.png)

Si on laisse de côté les conditions aux limites, on s'aperçoit que l'intégration par parties consiste à intégrer une des deux fonctions présentes dans l'intégrale initiale ( devient

devient  ) et à dériver l'autre (

) et à dériver l'autre ( devient

devient  ).

).

La sommation par parties consiste en une opération analogue dans le domaine discret, puisque l'une des deux séries est sommée ( devient

devient  ) et l'autre est différenciée (

) et l'autre est différenciée ( devient

devient ).

).

On peut considérer la formule sommatoire d'Abel comme une généralisation de ces deux formules.

Applications [modifier]

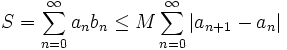

On se place par la suite dans le cas où  , car sinon on sait que

, car sinon on sait que  est grossièrement divergente.

est grossièrement divergente.

Si  est bornée par un réel M et que

est bornée par un réel M et que  est une série absolument convergente, alors la série

est une série absolument convergente, alors la série  est convergente.

est convergente.

La somme de la série vérifie par ailleurs l'inégalité :

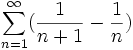

Exemples [modifier]

et

et

et

et

On sait que la série converge (voir fonction zêta de Riemann), donc les conditions exposées ci-dessus sont toutes réunies.

converge (voir fonction zêta de Riemann), donc les conditions exposées ci-dessus sont toutes réunies. converge.

converge.

NB: Cet exemple peut également être prouvé grâce au critère de convergence des séries alternées. et

et

(Nous ne définissons ici la somme qu'à partir du rang n=1 au lieu de n=0, mais cela n'affecte en rien l'existence de la limite de la série.)

Comme précédemment converge absolument, et

converge absolument, et  est bornée d'après l'expression du noyau de Dirichlet.

est bornée d'après l'expression du noyau de Dirichlet.

Par conséquent converge.

converge.- La sommation par parties sert dans la preuve du théorème d'Abel.

Voir aussi [modifier]

09:52 Publié dans Sommation par parties | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

20/11/2010

Lambda-calcul

Source : http://fr.wikipedia.org/wiki/Lambda-calcul

Lambda-calcul

« La notion de λ-définissabilité fut la première de ce qui est accepté maintenant comme l'équivalent exact des descriptions mathématiques pour lesquelles des algorithmes existent. »

— Stephen Kleene, in « Origins of Recursive Function Theory », IEEE Annals of the History of Computing, 1981, vol. 3, n°1, p. 52

Le lambda-calcul (ou λ-calcul) est un système formel inventé par Alonzo Church dans les années 1930, qui fonde les concepts de fonction et d'application. Il a été le premier formalisme utilisé pour définir et caractériser les fonctions récursives et donc il a une grande importance dans la théorie de la calculabilité, à l'égal des machines de Turing et du modèle de Herbrand-Gödel. Il a depuis été appliqué comme langage de programmation théorique et comme métalangage pour la démonstration formelle assistée par ordinateur. Le lambda-calcul peut être ou non typé.

Le lambda-calcul est apparenté à la logique combinatoire de Haskell Curry.

Syntaxe [modifier]

Le lambda calcul définit des entités syntaxiques que l'on appelle des lambda-termes (ou parfois aussi des lambda expressions) et qui se rangent en trois catégories :

- les variables : x, y... sont des lambda-termes ;

- les applications : u v est un lambda-terme si u et v sont des lambda-termes ;

- les abstractions : λ x.v est un lambda-terme si x est une variable et v un lambda-terme.

L’application peut être vue ainsi : si u est une fonction et si v est son argument, alors u v est le résultat de l'application à v de la fonction u.

L’abstraction λ x.v peut être interprétée comme la formalisation de la fonction qui, à x, associe v, où v contient en général des occurrences de x.

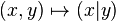

Ainsi, la fonction1 f qui prend en paramètre le lambda-terme x et lui ajoute 2 (c'est-à-dire en notation mathématique courante la fonction f: x ↦ x+2) sera dénotée en lambda-calcul par l'expression λ x.x+2. L'application de cette fonction au nombre 3 s'écrit (λ x.x+2)3 et s'« évalue » (ou se normalise) en l'expression 3+2.

Notations, conventions et concepts [modifier]

Parenthésage [modifier]

Pour délimiter les applications, on utilise des parenthèses, mais une utilisation trop abondante de parenthèses peut conduire à des expressions illisibles, donc pour raccourcir et clarifier les expressions, on supprime des parenthèses ; ainsi x1 x2 ... xn est équivalent à ((x1 x2) ... xn).

Il y a en fait deux conventions :

- Association à gauche, l'expression ((M0 M1) (M2M3)) s'écrit M0 M1 (M2M3). Quand une application s'applique à une autre application, on ne met de parenthèse que sur l'application de droite. Formellement, la grammaire du lambda calcul parenthésé est alors

- Λ ::= Var | λ var Λ | Λ (Λ)

- Parenthésage du terme de tête, l'expression ((M0 M1) (M2M3)) s'écrit (M0) M1 (M2) M3. Un terme entre parenthèses est le premier d'une suite d'applications. Ainsi les arguments d'un terme sont facilement identifiables. Formellement, la grammaire du lambda-calcul parenthésé est alors

- Λ ::= Var | λ var Λ | ΛΛ |Λ (Λ)

Curryfication [modifier]

Un lambda-terme ne prend qu'un seul argument, mais Shönfinkel et Curry ont introduit la curryfication et montré qu'on peut ainsi contourner cette restriction de la façon suivante : la fonction qui au couple (x, y) associe u est considérée comme une fonction qui, à x, associe une fonction qui, à y, associe u. Elle est donc notée : λx.(λy.u). Cela s'écrit aussi λx.λy.u ouλxλy.u ou tout simplement λxy.u. Par exemple, la fonction qui, au couple (x, y) associe x+y sera notée λx.λy.x+y ou plus simplement λxy.x+y.

Variables libres et variables liées [modifier]

Dans les expressions mathématiques en général et dans le lambda calcul en particulier, il y a deux catégories de variables : les variables libres et les variables liées (ou muettes). En lambda-calcul, une variable est liée2 par un λ. Une variable liée a une portée3 et cette portée est locale ; de plus, on peut renommer une variable liée sans changer la signification globale de l'expression entière où elle figure. Une variable qui n'est pas liée est dite libre.

Variables liées en mathématiques [modifier]

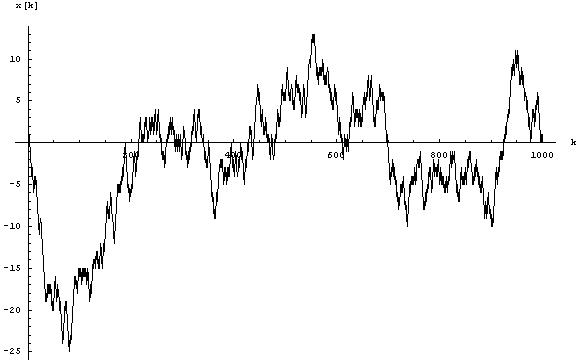

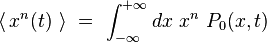

Par exemple dans  , x est libre, mais y est liée (par le dy). Ceci est la même expression que

, x est libre, mais y est liée (par le dy). Ceci est la même expression que  car y était un nom local, tout comme l'est z. Par contre

car y était un nom local, tout comme l'est z. Par contre  ne correspond pas à la même expression car le z est libre.

ne correspond pas à la même expression car le z est libre.

Tout comme l'intégrale lie la variable d'intégration, le λ lie la variable qui le suit.

Exemples: Dans λx.xy, la variable x est lié et la variable y libre. On peut récrire ce terme en λt.ty.

λxyzt.z(xt)ab(zsy) est équivalent à λwjit. i(wt)ab(isj)

Définition formelle des variables libres en lambda-calcul [modifier]

On définit l'ensemble VL(t) des variables libres d'un terme t par récurrence :

- si x est une variable alors VL(x) = {x}

- si u et v sont des lambda-termes alors VL(u v) = VL(u) ∪ VL(v)

- si x est une variable et u un lambda-terme alors VL(λx.u) = VL(u) {x}

Si un lambda-terme n'a pas de variables libres, on dit qu'il est clos (ou fermé) on dit aussi que ce lambda-terme est un combinateur (d'après le concept apparenté de logique combinatoire).

Substitution et α-conversion [modifier]

L'outil le plus important pour le lambda-calcul est la substitution qui permet de remplacer, dans un terme, une variable par un terme. Ce mécanisme est à la base de la réduction qui est le mécanisme fondamental de l'évaluation des expressions donc du « calcul » des lambda-termes.

La substitution dans un lambda terme t d'une variable x par un terme u est notée t[x := u]. Il faut prendre quelques précautions pour définir correctement la substitution afin d'éviter le phénomène de capture de variable qui pourrait, si l'on n'y prend pas garde, rendre liée une variable qui était libre avant que la substitution n'ait lieu. Par exemple, si u contient la variable libre y et si x apparaît dans t comme occurrence d'un sous terme de la forme λy.v, le phénomène de capture pourrait apparaître. L'opération t[x := u] s'appelle la substitution dans t de xpar u et se définit par récurrence sur t :

- si t est une variable alors t[x := u]=u si x=t et t sinon

- si t = v w alors t[x := u] = v[x := u] w[x := u]

- si t = λy.v alors t[x := u] = λy.(v[x := u]) si x≠y et t sinon

Remarque : dans le dernier cas on fera attention à ce que y ne soit pas une variable libre de u. En effet, elle serait alors « capturée » par le lambda externe. Si c'est le cas on renommey et toutes ses occurrences dans v par une variable z qui n'apparaît ni dans t ni dans u.

L'α-conversion identifie λy.v et λz.v[y := z]. Deux lambda-termes qui ne diffèrent que par un renommage (sans capture) de leurs variables liées sont dits α-convertibles. L'α-conversion est une relation d'équivalence entre lambda-termes.

Exemples :

- (λx.xy)[y := a] = λx.xa

- (λx.xy)[y := x] = λz.zx (et non λ x.xx, qui est totalement différent, cf remarque ci-dessus)

Remarque : l'α-conversion doit être définie avec précaution avant la substitution. Ainsi dans le terme λx.λy.xyλz.z, on ne pourra pas renommer brutalement x en y (on obtiendraitλy.λy.yyλz.z) par contre on peut renommer x en z.

Définie ainsi la substitution est un mécanisme externe au lambda-calcul, on dit aussi qu'il fait partie de la méta-théorie. A noter que certains travaux visent à introduire la substitution comme un mécanisme interne au lambda-calcul, conduisant à ce qu'on appelle les calculs de substitutions explicites.

Réductions [modifier]

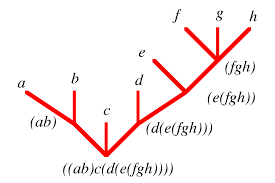

Une manière de voir les termes du lambda-calcul consiste à les concevoir comme des arbres ayant des nœuds binaires (les applications), des nœuds unaires (les λ-abstractions) et des feuilles (les variables). Les réductions4 ont pour but de modifier les termes, ou les arbres si on les voit ainsi ; par exemple, la réduction de (λx.xx)(λy.y) donne (λy.y)(λy.y).

On appelle rédex un terme de la forme (λx.u) v . On définit la bêta-contraction (ou β-contraction) de (λx.u) v comme u[x := v]; on dit qu'un terme C[u] se réduit5 en C[u'] si u est un redex qui se β-contracte en u', on écrit alors C[u]→C[u'], la relation → est appelée réduction.

Exemple de réduction :

(λx.xy)a donne (xy)[x := a] = ay .

On note →* la fermeture réflexive transitive6 de la relation → de réduction et =β sa fermeture réflexive symétrique et transitive (appelée bêta-conversion ou bêta-équivalence).

La β-conversion permet de faire une "marche arrière" à partir d'un terme. Cela permet, par exemple, de retrouver le terme avant une β-réduction. Passer de x à (λy.y)x .

On peut écrire M =β M' si ∃ N1, ..., Np tels que M = N1, M'=Np et Ni→ Ni+1 ou Ni+1→ Ni .

Cela signifie que dans une conversion on peut appliquer des réductions ou des relations inverses des réductions (appelées expansions).

On définit également une autre opération, appelée êta-réduction (ou son inverse la êta-expansion), définie ainsi : λx.ux →η u, lorsque x n'apparait pas libre dans u. En effet, ux s'interprète comme l'image de x par la fonction u. Ainsi, λx.ux s'interprète alors comme la fonction qui, à x, associe l'image de x par u, donc comme la fonction u elle-même.

Enfin, si on s'est donné des primitives, on peut fixer leur comportement calculatoire au moyen des règles de delta-réduction. Par exemple, si on s'est donné les entiers et + comme termes supplémentaires, les tables d'addition serviront de delta-règles. Comme les primitives sont par définition complètement étrangères au lambda-calcul, leurs règles de calcul peuvent a priori adopter n'importe quelle forme. Toutefois, si on veut étendre les propriétés mentionnées ci-dessous au cas d'un calcul avec des primitives, on est amené à faire quelques hypothèses sur les règles ajoutées.

La normalisation : notion de calcul [modifier]

Le calcul associé à un lambda-terme est la suite de réductions qu'il engendre. Le terme est la description du calcul et la forme normale du terme7 (si elle existe) en est le résultat.

Un lambda-terme t est dit en forme normale si aucune bêta-contraction ne peut lui être appliquée, c'est-à-dire si t ne contient aucun rédex. Ou encore, s'il n'existe aucun lambda-terme utel que t → u.

Exemple: λx.y(λz.z(yz)) .

On dit qu'un lambda-terme t est normalisable s'il existe un terme u tel que t =β u. Un tel u est appelé la forme normale de t.

On dit qu'un lambda-terme t est fortement normalisable si toutes les réductions à partir de t sont finies.

Exemples:

-

- Posons Δ ≡ λx.xx . L'exemple par excellence de lambda-terme non fortement normalisable est obtenu en appliquant ce terme à lui même, autrement dit:

- Ω = (λx.xx)(λx.xx) = ΔΔ

Le lambda terme Ω n'est pas fortement normalisable car sa réduction boucle indéfiniment sur elle-même. - (λx.xx)(λx.xx) → (λx.xx)(λx.xx).

- (λx.x)((λy.y)z) est un lambda-terme fortement normalisable.

- (λx.y)(ΔΔ) est normalisable et sa forme normale est y, mais il n'est pas fortement normalisable.

- (λx.xxx)(λx.xxx) → (λx.xxx)(λx.xxx)(λx.xxx) → (λx.xxx)(λx.xxx)(λx.xxx)(λx.xxx) → ... crée des termes de plus en plus grand.

Si un terme est fortement normalisable, alors il est normalisable.

Théorème de Church-Rosser : soient t et u deux termes tels que t =β u. Il existe un terme v tel que t →* v et u →* v.

Théorème du losange (ou de confluence) : soient t, u1 et u2 des lambda-termes tels que t →* u1 et t →* u2. Alors il existe un lambda-terme v tel que u1 →* v et u2 →* v.

Grâce au Théorème de Church-Rosser on peut facilement montrer l'unicité de la forme normale ainsi que la cohérence du lambda-calcul (c’est-à-dire qu'il existe au moins deux termes distincts non bêta-convertibles).

Différents lambda-calculs [modifier]

Sur la syntaxe et la réduction du lambda-calcul on peut adapter différents calculs en restreignant plus ou moins la classe des termes. On peut ainsi distinguer deux grandes classes de lambda-calculs : le lambda-calcul non typé et les lambda-calculs typés. Les types sont des annotations des termes qui ont pour but de ne garder que les termes qui sont normalisables, éventuellement en adoptant une stratégie de réduction. On espère8 ainsi avoir un lambda-calcul qui satisfait les propriétés de Church-Rosser et de normalisation.

La correspondance de Curry-Howard relie un lambda calcul typé à une système de déduction naturelle. Elle énonce qu'un type correspond à une proposition et un terme correspond à une preuve, et réciproquement.

Le lambda-calcul non typé [modifier]

Des codages simulent les objets usuels de l'informatique dont les entiers naturels, les fonctions récursives et les machines de Turing. Réciproquement le lambda-calcul peut être simulé par une machine de Turing. Grâce à la thèse de Church on en déduit que le lambda-calcul est un modèle universel de calcul.

Les booléens [modifier]

Dans la partie Syntaxe, nous avons vu qu'il est pratique de définir des primitives. C'est ce que nous allons faire ici.

- vrai = λab.a

- faux = λab.b

Ceci n'est que la définition d'un codage, et l'on pourrait en définir d'autres.

Nous remarquons que :

- vrai x y →* x